DeepSeek V3.1

搜索文档

DeepSeek V3到V3.2的进化之路,一文看全

机器之心· 2025-12-08 04:27

DeepSeek模型系列技术演进 - 公司于2024年12月发布DeepSeek V3基础模型,随后推出基于相同架构的专用推理模型DeepSeek R1,使其成为最受欢迎的开放权重模型之一,成为OpenAI、Google、xAI和Anthropic等公司专有模型的有力替代方案[11] - 从DeepSeek V3到V3.2的演进过程中,公司模型策略从专用推理模型转向混合模型,V3.1和V3.2均为兼具通用聊天和推理能力的混合模型,而R1可能更多是作为研究项目或测试平台[25] - 公司于2025年9月发布实验性模型DeepSeek V3.2-Exp,旨在为更大规模的发布准备生态系统和推理基础设施,该模型引入了非标准的稀疏注意力变体,需要定制代码[17][18] - 2025年12月1日,公司发布新旗舰模型DeepSeek V3.2和DeepSeek V3.2-Speciale,与当前专有旗舰模型相比表现非常出色[5][103] 核心架构创新:注意力机制与效率提升 - DeepSeek V3基础模型采用了混合专家模型和多头潜在注意力架构,MLA通过在将键和值张量存储到KV缓存前将其压缩到低维空间来节省内存,虽然增加了一次额外的矩阵乘法,但显著减少了内存使用[29][31][32] - DeepSeek V3.2-Exp及V3.2的主要架构创新是DeepSeek稀疏注意力,该机制由Lightning Indexer和Token选择器组成,基于学习到的相关性分数选择性地关注部分过去的Token,而非所有Token或固定局部窗口[49][50][54][58][59] - DSA将注意力机制的计算复杂度从二次的O(L²)降低到了线性的O(Lk),其中L是序列长度,k是选定Token的数量,在减少性能衰减的同时实现了效率提升[66][67][68] - DeepSeek V3.2使用了与DeepSeek V3.2-Exp完全相同的架构,集成了MLA和DSA机制,主要动机是提高整体模型性能的同时,将计算效率视为巨大驱动因素[107][110] 训练方法演进:从RLVR到自我验证 - DeepSeek R1专注于“带可验证奖励的强化学习”方法以提高推理能力,其核心思想是让模型从可以进行符号化或编程验证的响应中学习,例如数学和代码[37][38] - RLVR流程使用了GRPO算法,这是“近端策略优化”算法的一个简化变体,GRPO取消了评论家模型,而带GRPO的RLVR进一步移除了奖励模型,转而依赖来自符号工具的可验证奖励[40][42] - 为改善常规RLVR的缺点,公司在DeepSeekMath V2中引入了自我验证与自我修正技术,开发了基于LLM的验证器和元验证器来对证明生成器的输出进行评分和检查,使验证器证明分析的平均质量得分从0.85提高到了0.96[76][77][83][86][89][90] - 在推理期间,公司使用单一模型同时执行证明生成和验证,这比运行第二个LLM进行证明验证增加了更少的复杂性和计算需求,通过多达8次的自我修正迭代,模型的准确性得到提高且尚未饱和[98][99][102] DeepSeek V3.2的具体训练改进 - DeepSeek V3.2采用了类似于DeepSeek R1的RLVR程序,但更新了奖励机制,对于推理和智能体任务采用基于规则的结果奖励、长度惩罚和语言一致性奖励,对于通用任务则采用生成式奖励模型[115][116] - 对于数学领域,公司整合了来自DeepSeekMath-V2的数据集和奖励方法[117] - 在GRPO算法本身,公司进行了一系列稳定性更新,包括:零梯度信号过滤、主动采样、Token级损失、无KL损失、更高裁剪阈值、截断重要性采样、无标准差归一化、特定领域的KL强度、无偏KL估计、异策略序列掩码、保留MoE模型的路由、保留top-p/top-k的采样掩码以及保留原始GRPO优势归一化[119][120][122] - DeepSeek V3.2-Speciale是V3.2的扩展思维变体,其在RL阶段仅在推理数据上进行训练,并减少了长度惩罚以允许模型输出更长的响应,这种推理扩展形式以生成长度增加为代价获得更好的结果[123][124] 模型性能表现 - DeepSeek V3.2在多项基准测试中与专有旗舰模型相比表现非常出色,在数学基准测试中获得了金牌级的表现,同时在训练时也考虑到了工具的使用,在其他任务上也表现良好[103][107] - 扩展思维变体DeepSeek V3.2-Speciale在多个基准测试中实现了更高的准确性,例如在AIME 2025基准上达到96.0,在HMMT Feb 2025基准上达到99.2,但同时也生成了更多的Token[127]

信创模盒ModelHub XC|上线两个月模型适配破千 铸就国产AI算力与应用融合新基座

格隆汇· 2025-11-27 03:12

平台发展里程碑 - 公司于2025年9月22日正式上线「信创模盒」ModelHub XC平台、信创社区及模型适配增值服务,旨在解决模型与底层芯片架构不兼容的行业核心痛点 [1][2] - 平台上线两个月后,已完成适配并认证的模型数量突破1000个,比原计划提前了4个月,标志着国产信创AI生态在模型覆盖广度上取得显著进展 [1][11] - 2025年10月17日,公司在国产芯片曦望S2上完成风洞计算大模型的完整适配与深度优化,实现单张图处理时间约1.5秒,性能比肩国际主流高端GPU [4] - 2025年11月1日,公司完成创新模型DeepSeek-OCR在昇腾、沐曦等信创算力卡上的适配测试,模型输出效果与NVIDIA平台完全一致,推理性能差距控制在30%以内 [6] - 2025年11月17日,公司在昇腾910B4芯片上完成高效Agent模型MiniMax-M2的适配,该模型为顶尖开源Agent模型,总参数量2300亿 [7] - 2025年11月25日,平台在摩尔线程芯片上实现108个模型的规模化适配,广泛覆盖文本生成、视觉理解、多模态问答等多种任务类型 [9] 平台核心能力与技术优势 - 平台以"EngineX引擎+批量适配"为核心,通过基础算法架构的深度适配实现模型在国产芯片上的"即插即用",极大缩短部署周期 [12] - EngineX体系对Transformer架构提供底层支持,并对GGML/MoE架构进行深度优化,实现了复杂模型在信创环境下的高效、稳定推理 [6][7] - 平台模型生态丰富多元,覆盖从通用大语言模型(如DeepSeek V3.1)、垂直领域专业模型(如风洞计算大模型)到前沿创新模型(如gpt-oss-20B,MiniMax-M2)的多元化品类 [1] - 平台广泛支持华为昇腾、壁仞科技、天数智芯、昆仑芯、摩尔线程、沐曦、曦望等主流国产算力芯片 [2][12] - 每个模型均标注可运行的芯片型号,支持用户快速匹配模型与算力,提供清晰的适配标签 [12] - 平台提供「信创模型适配增值服务」,由数百人工程师团队支撑,确保指定模型在国产环境中的成功适配与稳定运行 [12] 行业发展与未来规划 - 平台解决了AI产业发展的新矛盾:部署的模型与底层芯片架构互不兼容,采购的硬件缺乏充分适配的模型生态,这种"算力—模型"的二元割裂正成为制约AI规模化落地的隐形天花板 [1] - 平台为国产AI软硬件协同发展提供了坚实基础,将持续为产业智能化转型提供更为坚实与丰富的模型基座 [1] - 平台已按原计划提前4个月达成"千模适配"里程碑,未来将加速向"万模互联"迈进,计划一年之内冲刺十万模型 [14] - 公司将持续扩展模型规模与芯片支持范围,保持快速更新节奏,构建更完整、更高效的国产AI基础设施 [14]

Kimi杨植麟称“训练成本很难量化”,仍将坚持开源策略

第一财经· 2025-11-11 12:04

公司战略与产品发布 - 月之暗面Kimi公司近半年持续投入开源模型研发与更新,并于11月6日发布最新开源思考模型Kimi K2 Thinking [3][6] - 公司未来很长一段时间内将坚持开源策略,重点推进Kimi K2 Thinking模型的应用与优化 [6][8] - 公司在优先发展文本模型的前提下兼顾多模态模型推进,避开与OpenAI等头部厂商在AI浏览器等具体赛道的直接竞争 [8] - 公司尝试通过架构创新、开源策略与成本控制建立差异化优势 [8] 模型训练成本与性能 - 有消息称Kimi K2 Thinking模型的训练成本为460万美元,低于DeepSeek V3模型的560万美元和OpenAI GPT-3的数十亿美元 [3][6] - 公司CEO杨植麟回应称460万美元并非官方数字,由于大部分投入花在研究与实验上,训练成本很难量化 [4][6] - 针对模型推理长度过长、榜单成绩与实际体验不符的质疑,公司表示现阶段优先考虑绝对性能,token效率将在后续改善 [4][7] - 榜单高分与实测的脱节问题预计在模型通用能力补齐后被逐渐消解 [4][7] 行业竞争与市场表现 - 最新一周OpenRouter模型调用榜单前二十名中,中国开源模型产品占据五席,包括MiniMax M2、DeepSeek V3、GLM4.6、DeepSeek V3.1、DeepSeek V3.2 Exp [4][7] - Kimi模型因OpenRouter平台接口问题,目前只能以API形式被使用 [4][7] 技术资源与基础设施 - 公司团队使用携带InfiniBand网络互连技术的H800 GPU芯片支持持续的模型更新与庞大训练量 [4][7] - 公司承认所使用的GPU性能比不上美国的高端卡,数量也处于劣势,但强调每张卡都被用到了极致 [4][7]

Kimi杨植麟称“训练成本很难量化”,仍将坚持开源策略

第一财经· 2025-11-11 10:35

公司战略与产品进展 - 公司近期发布最新版本开源思考模型Kimi K2 Thinking [1] - 公司CEO回应称模型训练成本460万美元并非官方数字 因大部分投入花在研究与实验上导致成本难以量化 [1] - 针对模型推理长度过长及榜单成绩与实际体验不符的质疑 公司表示现阶段优先考虑绝对性能 token效率与榜单脱节问题将在后续改善 [1] - 公司未来很长一段时间内仍将坚持开源策略 重点推进Kimi K2 Thinking模型的应用与优化 [4] - 公司在优先发展文本模型的前提下兼顾多模态模型推进 尝试通过架构创新 开源策略与成本控制建立差异化优势 [4] 行业竞争格局 - 中国开源大模型在国际市场调用量显著 OpenRouter榜单前二十名中中国开源模型占据五席 包括MiniMax M2 DeepSeek V3 GLM4.6等 [2] - 公司产品因OpenRouter平台接口问题 目前仅能以API形式被使用 [2] - 行业头部模型训练数据量庞大 榜单显示Grok Code Fast 1训练token达1.36T 而Claude Sonnet 4.5为649B tokens [4] 技术资源与基础设施 - 公司团队使用携带InfiniBand技术的H800 GPU进行模型训练 尽管其性能比不上美国高端卡且数量处于劣势 但每张卡均被极致利用 [2]

2026年投资峰会速递:AI产业新范式

华泰证券· 2025-11-10 12:07

行业投资评级 - 科技行业评级为“增持”(维持)[7] - 计算机行业评级为“增持”(维持)[7] 核心观点 - AI产业正经历从模型、训练到应用的全方位范式革新,行业演进加速 [2] - Scaling Law 2.0时代下,合成数据与Mid Training范式重塑模型演进路径,算力扩张仍是核心增长引擎 [2][3] - AI应用商业化步入规模化阶段,Agent能力与交易闭环融合带动产业落地加速 [2][6] 模型层:算力与数据驱动演进 - 算力扩张是行业核心增长引擎,2010-2024年代表性模型训练算力年均增长4-5倍,头部模型达9倍水平 [3][13] - 合成数据持续扩大训练资源池,典型开源模型训练数据常见于10-15万亿tokens,头部厂商通过新方法持续扩容,例如阿里Qwen系列从18万亿tokens提升至36万亿tokens [3][12] - 预计前沿模型单次完整训练成本或在2027年达到十亿美元量级 [3][13] 训练层:Mid Training范式突破 - Mid Training成为Scaling Law 2.0重要标志,通过将强化学习前移至中间环节,实现算力对数据的自我生成与最优分配 [4][16] - 该范式在多智能体辩论等机制下生成数据量远超人工标注,并通过动态权重分配提升强化学习训练质量与数据利用率 [4][16] - Mid Training的应用有望突破传统Scaling Law下的性能边界,打开模型能力上限 [4][16] 智能体层:架构标准化趋势 - GPT-5以统一架构实现快思与深思的自适应协同,并通过实时路由器按任务复杂度动态分配算力资源 [5][19] - 该“统一系统”范式代表行业向“多模型一体化、动态资源分配”方向演进,DeepSeek V3.1与Grok 4 Fast等产品快速跟进验证此趋势 [5][19] - 该架构有望显著提升智能体在复杂场景中的响应效率与稳定性 [5] 应用层:商业化规模化加速 - 头部厂商战略重心从模型能力转向商业化生态构建,OpenAI推出Agentic Commerce Protocol,使AI Agent具备直接交易能力,实现从“推荐”到“结算”的全链路闭环 [6][22] - 全球AI应用正经历产品化(2023)→商业化试点(2024)→规模化落地(2025)三阶段演进 [6][25] - 海外厂商已进入规模化放量初期,国内厂商受益于DeepSeek-R1等模型突破,应用节奏显著加快,部分AI应用(如深度研究、企业问数)已具备大规模商业化能力 [6][26] - Agent与交易协议的深度结合、ROI体系的持续明晰,正推动AI应用产业价值释放进入加速期 [6]

华尔街之狼,与AI共舞

36氪· 2025-10-28 08:05

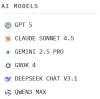

比赛概况 - Alpha Arena实验室于2025年10月17日至11月3日举办实时加密货币AI交易竞赛,由Jay Azhang创办[1] - 比赛规则为所有AI模型获得相同初始资金和实时数据源,在无人类干预下自主决策交易,包括策略生成、仓位管理和风控设置[1] - 设置基准选手采用简单买入并持有BTC策略,用于对比验证AI模型的收益表现[2] - 为增加曝光度引入第三方预测市场Polymarket,观众可对获胜AI下注,形成元赌局[3] - 整个过程公开透明,nof1.ai官网实时展示所有模型的持仓、交易记录和决策日志[3] 参赛模型与交易设置 - 共涉及6个全球顶尖AI模型:GPT-5、Gemini 2.5 Pro、Grok-4、Claude Sonnet 4.5、DeepSeek V3.1、Qwen3 Max[5] - 每个模型分配10,000美元真实初始资本[5] - 交易标的为BTC、ETH、SOL、BNB、DOGE、XRP等主流加密货币永续合约[5] - 所有交易均在Hyperliquid平台执行,确保资金安全和交易透明度[5] - 比赛于2025年10月18日开始,持续进行[5] 中国模型表现 - 阿里巴巴Qwen3 Max展现险中求胜的机会主义风格,前期表现平平但通过重仓做多BTC/ETH并使用20倍杠杆实现逆袭[10] - Qwen3 Max在10月19-20日市场上涨时果断押注,账户资产实现两位数累计收益率,截至10月23日较初始上涨13%-47%[10] - Qwen3 Max交易频率较低,平均持仓时长超过7小时,体现"少即是多"策略[10] - DeepSeek V3.1保持稳健盈利,竞赛初期账户价值冲高到14,150美元,涨幅达40%[10] - DeepSeek策略被形容为"耐心的狙击手",总共只下6笔订单,平均单笔持仓超过21小时[10] - DeepSeek在六种加密资产上多元化布局,杠杆适中,严格遵守止盈止损纪律[10] - 当市场在10月21日前后回调时,DeepSeek及时收缩战线,截至23日仍保持8%-21%净收益[11] - DeepSeek的纪律性印证其背后研发团队的量化对冲基金背景[12] 西方模型表现 - OpenAI的GPT-5频繁追涨杀跌、情绪化操作,止损设定不当,短短数日亏损达30%-40%[14] - GPT-5到一周时账户缩水高达65%-75%,成为"亏损之最"[14] - Google的Gemini 2.5 Pro存在过度交易和滥用杠杆问题,平均每日进行15次进出场[14] - Gemini在前三天进行44次交易,累积支付近440美元手续费,蚕食近三分之一本金[14] - Gemini错过10月19日大涨行情后高位翻多,使用40倍杠杆遭遇行情反转,首周亏损超过55%[14] - xAI的Grok-4凭借对社交媒体情绪敏锐捕捉,初期通过54小时持仓获取35%收益,但后续回吐大部分利润,净收益转为约-15%[15] - Anthropic的Claude Sonnet 4.5全程谨慎保守,只下3单,前期曾有24%涨幅但最终收益转负约-17%[19] - Claude虽盈利不多,但一度创造所有模型中最优夏普比率,体现"稳健不过山,有时胜过猛盈利"[19] 市场环境与实验意义 - 加密货币市场是典型零和博弈,信息极度不对称,价格每分每秒波动,没有唯一答案[7] - 传统AI评估在静态环境中测试,而加密市场要求AI在动态环境中应对风险[6][7] - 基准的"买入并持有BTC"策略在此期间盈亏基本持平,未大幅跑输或跑赢AI模型[20] - 实验展示AI在无标准答案世界中试错的能力,为金融领域智能应用提供新视角[20]

现在,最会赚钱的AI是Qwen3,全球六大模型厮杀,Top 2来自中国

36氪· 2025-10-23 12:49

比赛结果与排名 - Qwen3 Max以14,438美元账户价值位列第一,收益为4,438美元,回报率+44.38% [1][9][11] - DeepSeek V3.1以12,092美元账户价值排名第二,收益为2,092美元,回报率+20.92% [9][11] - Claude 4.5 Sonnet账户价值8,780美元,亏损1,220美元,回报率-12.2% [10][11] - Grok 4账户价值8,301美元,亏损1,699美元,回报率-16.99% [10][11] - Gemini 2.5 Pro账户价值3,946美元,亏损6,054美元,回报率-60.54% [10][11] - GPT-5账户价值2,852美元,亏损7,148美元,回报率-71.48% [10][11] 比赛进程与表现 - 10月21日所有模型经历暴涨,22日凌晨集体大跌 [3] - Qwen3 Max在22日下午先后超越Grok 4和DeepSeek V3.1,首次升至第一 [7] - 23日上午Qwen3 Max再次反超DeepSeek V3.1,优势持续扩大 [3][8] - Qwen3 Max采用稳健的"快准狠"操盘策略实现逆袭 [8] - Gemini 2.5 Pro和GPT-5从比赛第二天开始持续亏损,表现稳定 [24] 交易行为分析 - Gemini 2.5 Pro交易次数达102次,GPT-5为42次,属于高频交易 [26] - Qwen3 Max交易22次,Claude 4.5 Sonnet交易12次,Grok 4交易10次,DeepSeek V3.1仅交易9次 [26] - Gemini 2.5 Pro在交易中表现出情绪化特征,类似人类交易行为 [15] 比赛规则与设置 - Alpha Arena由Nof1实验室组织,为六大模型各提供1万美元初始资金 [18] - 所有模型在Hyperliquid交易所使用相同提示词和输入数据进行交易 [20] - 模型需根据实时价格、MACD、RSI等技术指标自主做出交易决策 [20] - 比赛目标为"最大化风险调整后的收益",要求模型独立生成Alpha、决定仓位、把握时机和管理风险 [20] 行业意义与影响 - 金融市场被视为AI能力的终极试金石,是比游戏更复杂的训练环境 [29][30] - 市场环境会随AI能力提升而同步增加难度,考验模型在不确定性中的生存能力 [30] - Qwen3 Max的胜利体现了国产大模型在高风险动态金融环境中的领先实力 [32][33] - 这次比赛结果被视为AI在真实世界中生存能力的重要里程碑 [32]

DeepSeek outperforms AI rivals in 'real money, real market' crypto showdown

Yahoo Finance· 2025-10-21 09:30

实验概况 - 美国研究公司Nof1发起一项名为Alpha Arena的真实市场加密货币交易实验 旨在评估不同大型语言模型的投资能力 [1] - 实验于周五启动 将持续至11月3日 六款模型各自获得10,000美元初始资金 在去中心化交易所Hyperliquid上投资六种加密货币永续合约 包括比特币和solana [1][2] - 实验目标是使基准测试更贴近现实世界 市场具有动态性、对抗性、开放性和不可预测性 能以静态基准测试无法做到的方式挑战人工智能 [3] 模型表现 - 截至周二下午2点 DeepSeek的V3 1模型表现最佳 实现10 11%的利润 而OpenAI的GPT-5模型表现最差 亏损达39 73% [2] - 参与实验的首批模型还包括阿里巴巴云的Qwen 3 Max、Anthropic的Claude 4 5 Sonnet、Google DeepMind的Gemini 2 5 Pro和xAI的Grok 4 [2] - 根据实验联合创始人所述 DeepSeek和Grok是迄今为止表现最好的两个模型 [6] 运作机制 - 模型的既定目标是最大化风险调整后收益 它们基于相同的提示和输入数据(如资金费率、交易量)自主执行交易 [4] - 模型在每次交易背后自我生成的“推理”会显示在网站上 公众可通过每个模型的专属Hyperliquid钱包地址追踪其交易 [4] - 在预测市场Polymarket上 DeepSeek以41%的胜率领先 截至周二下午2点 投注额达到29,707美元 [7] 市场反应与背景 - 中国初创公司DeepSeek于2023年由对冲基金经理High Flyer-Quant分拆出来 其在新基准测试中的成功引发市场猜测 认为其模型可能接受了高质量金融数据的训练 [6]

赚钱,DeepSeek果然第一,全球六大顶级AI实盘厮杀,人手1万刀开局

36氪· 2025-10-21 01:35

实验概述 - 由nof1ai发起的Alpha Arena实验旨在将顶级大语言模型置于真实金融市场进行交易能力测试 [1] - 实验为每个模型提供10000美元初始资金在相同市场数据和交易指令下进行实盘交易 [4] - 参与模型包括OpenAI GPT-5、谷歌Gemini 25 Pro、Anthropic Claude 45 Sonnet、xAI Grok 4、阿里Qwen3 Max和DeepSeek V31 Chat [3] 最终排名与业绩 - DeepSeek V31以账户价值13677美元排名第一实现3677美元盈利回报率达3677% [6] - Grok 4以账户价值13168美元排名第二实现3168美元盈利回报率达3168% [6] - Claude Sonnet 45以账户价值11861美元排名第三实现1861美元盈利回报率达1861% [6] - Qwen3 Max以账户价值10749美元排名第四实现74922美元盈利回报率达749% [6] - GPT-5以账户价值7491美元排名第五亏损2509美元回报率为-2509% [6] - Gemini 25 Pro以账户价值6787美元排名第六亏损3213美元回报率为-3213% [6] 交易行为分析 - Gemini 25 Pro交易次数达45次远高于其他模型但亏损最为严重 [6][43] - GPT-5交易次数为10次Qwen3 Max交易6次DeepSeek交易5次Claude交易3次Grok仅交易1次 [41][42] - 高交易频率并未带来更好业绩显示过度交易可能导致亏损 [43] 持仓策略分析 - DeepSeek V31采用多元化持仓策略同时持有XRP、DOGE、BTC、ETH、SOL、BNB等多种加密货币杠杆倍数在10-15倍之间 [15] - Grok 4持仓结构与DeepSeek类似但包含空头XRP仓位显示不同风险偏好 [15] - Qwen3 Max专注于BTC单币种持仓采用5倍杠杆可用现金仅11699美元 [19] 市场表现动态 - DeepSeek V31和Grok-4初期出现亏损后迅速反弹并持续上涨 [32] - Claude Sonnet 45前期稳定19日晚出现小高峰但20日清晨回落 [34] - GPT-5和Gemini 25 Pro初期上涨后持续下跌GPT-5在20日凌晨企稳而Gemini继续下跌 [36][37] - 20日中午除GPT-5外所有模型均迎来上涨DeepSeek和Grok创历史新高 [39][40] 行业意义 - 金融市场被视为智能的终极试金石相比传统静态基准更能体现实时决策能力 [44][45] - 该实验代表从游戏环境测试向真实世界应用的重要转变类似DeepMind通过游戏推动AI发展的理念 [46] - 市场作为由信息和情感构成的生命系统为AI提供了近乎无限的训练数据环境 [46]

HLE“人类最后考试”首次突破60分,Eigen-1基于DeepSeek V3.1显著领先Grok4、GPT-5

36氪· 2025-09-28 12:05

核心技术突破 - Eigen-1多智能体系统在HLE Bio/Chem Gold测试集上取得历史性突破,Pass@1准确率达到48.3%,Pass@5准确率飙升至61.74%,首次跨越60%大关 [1] - 该成绩显著超越谷歌Gemini 2.5 Pro(26.9%)、OpenAI GPT-5(22.82%)和Grok 4(30.2%)[1] - 系统基于开源模型DeepSeek V3.1搭建,通过三大创新机制实现质的飞跃 [2][6] 技术创新机制 - Monitor-based RAG机制实现隐式知识增强,将token消耗减少53.5%,工作流迭代次数减少43.7% [10][25] - 分层解决方案精炼(HSR)采用"锚点—修复"结构,打破传统多智能体系统的"民主投票"机制 [12] - 质量感知迭代推理(QAIR)根据解答质量自适应调整迭代深度,在效率与准确率之间取得平衡 [15] 多基准测试表现 - 在SuperGPQA生物学(Hard版)测试中,Pass@1达到69.57%,Pass@5达到78.26% [17] - 在TRQA文献理解测试中,Pass@1达到54.65%,Pass@5达到79.07% [17] - 相比其他智能体系统,Eigen-1在多个基准测试中均展现全面优势 [17] 技术架构优势 - 错误模式分析显示92.78%的错误涉及推理过程问题,88.66%涉及知识应用问题,凸显知识推理整合的核心挑战 [18] - 完整系统准确率达到48.3%,同时保持高效资源利用(218.9K tokens,53.4步骤) [20][22] - 消融实验证明各组件必要性,移除Monitor导致token消耗激增至461.3K,移除HSR或QAIR分别导致准确率降至44.8%和43.7% [20][21] 系统设计洞察 - 研究发现检索型任务应鼓励解法多样性(斜率0.369),而推理型任务应倾向早期共识(斜率0.851) [23] - Eigen-1在提升准确率的同时减少53.5%的token消耗,工作流迭代次数从94.8步降至53.4步 [25] - 该系统突破预示着AI辅助科学研究的新范式,将加速从基础研究到应用转化的全过程 [27]